Head vs breakz

[인공지능] - 활성화 함수 본문

-

활성화 함수

-

노드에 들어온 값(xw)들에 대해서 출력값에 대해서 활성화을 할것인지 결정

-

Data를 비선형으로 바꾸기 위해 사용

-

-

sigmoid

-

S 자 모양을 가지는 함수

-

초창기에 많이 사용한 함수

-

중심을 기준으로 왼쪽은 0, 오른쪽은 1로 수렴하는 함수

-

모든 구간에서 미분이 가능한 특징

-

Vanishing gradient problem 발생

-

-

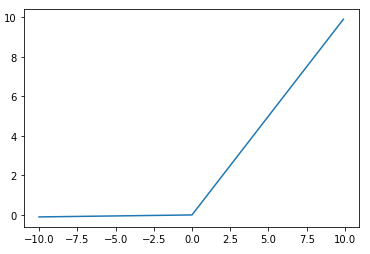

ReLU

-

sigmoid의 Vanishing gradient problem 해결하는 함수

-

-

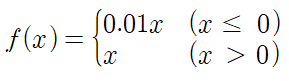

Leaky ReLU

-

Dying ReLu 현상을 해결하는 함수

-

-

Softmax

-

분류 할때 사용

-

모델의 출력층에서 입력데이터가 어떤 클래스로 분류되는지에 대한 확률값

-

각 출력값들의 합은 1

-

지수함수를 사용하여, 값이 급격하게 증가하여 overflow 발생

-

-

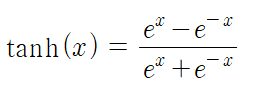

hyperbolic Tangent

-

쌍곡선 함수

-

sigmoid 함수를 통해 만듬

-

Vanishing gradient problem 발생

-

참조&도움

'Head > 인공지능' 카테고리의 다른 글

| [인공지능] - 가중치 규제 (0) | 2020.02.03 |

|---|---|

| [인공지능] - YOLO (0) | 2020.01.29 |

| [인공지능] - dropout (0) | 2020.01.23 |

| [인공지능] - Optimizer (0) | 2020.01.23 |

| [인공지능] - 최적의 가중치 찾기 (0) | 2020.01.21 |

Comments